要了解搜索引擎的工作原理,我们可以将搜索引擎的工作分为三个不同的阶段:爬取、索引和检索。

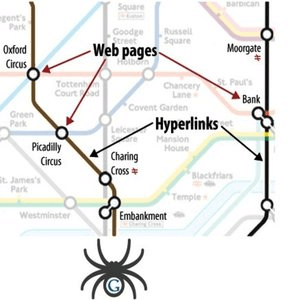

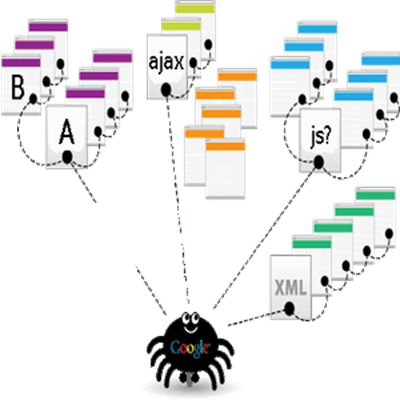

爬行:它由称为网络蜘蛛或网络爬虫的软件机器人执行。 每个搜索引擎都有自己的网络蜘蛛来执行爬行。 在这一步中,蜘蛛会访问网站或网页并阅读它们,然后点击链接到该网站的其他网页。 因此,通过爬行,他们可以找出在万维网上发布的内容。 一旦爬虫访问一个页面,它就会复制该页面并将其 URL 添加到索引中。

网络蜘蛛通常从使用频繁的服务器和流行的网页开始爬行。 它遵循由链接结构确定的路线,并通过新的链接找到新的互连文档。 它还会重新访问以前的站点以检查网页中的更改或更新。 如果发现更改,它会复制更改以更新索引。

索引:它涉及在爬取万维网上找到的所有网站或网页后建立索引。 爬取站点的索引是根据它们提供的信息的类型和质量进行的,并存储在巨大的存储设施中。 它就像一本书,包含蜘蛛爬取的每个网页的副本。 因此,它从互联网上收集和组织信息。

检索: 在此步骤中,搜索引擎通过按特定顺序提供具有相关答案或信息的网站列表来响应用户的搜索查询。 它将提供独特和原始信息的相关网站保留在搜索引擎结果页面的顶部。 因此,每当用户执行在线搜索时,搜索引擎都会在其数据库中搜索具有相关信息的网站或网页,并根据它们的相关性制作这些网站的列表,并将此列表呈现给搜索引擎结果页面上的用户 .