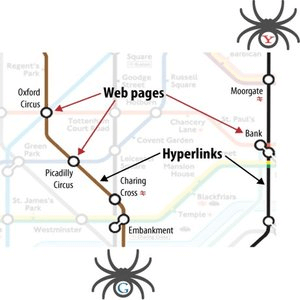

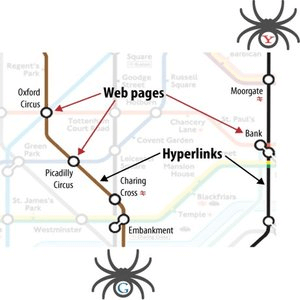

抓取是指使搜索引擎能够访问网页并收集 URL 以进行索引的自动化过程。 当爬虫访问一个页面时,它会复制该页面并将其 URL 添加到索引中,这称为索引。 搜索引擎具有用于爬行的软件机器人,称为网络蜘蛛或网络爬虫。

爬虫不仅读取页面,还跟踪内部和外部链接。 因此,他们可以找出在万维网上发布的内容。 爬虫还会重新访问以前的站点以检查其网页中的更改或更新。 如果发现更改,它会相应地更新索引。

42、搜索引擎抓取是什么?

42、搜索引擎抓取是什么?

抓取是指使搜索引擎能够访问网页并收集 URL 以进行索引的自动化过程。 当爬虫访问一个页面时,它会复制该页面并将其 URL 添加到索引中,这称为索引。 搜索引擎具有用于爬行的软件机器人,称为网络蜘蛛或网络爬虫。

爬虫不仅读取页面,还跟踪内部和外部链接。 因此,他们可以找出在万维网上发布的内容。 爬虫还会重新访问以前的站点以检查其网页中的更改或更新。 如果发现更改,它会相应地更新索引。